Big Data Management

Ein Big Data Thema entsteht immer dann, wenn Geschäftsprozesse nach Lösungen verlangen, die große Datenmengen in kurzer Zeit verarbeiten müssen und die vorhandene Technologie dazu nicht in der Lage ist. Um die konsistente Kundenansprache über alle Kontaktpunkte (Omni-Channel) sicherzustellen und das richtige Produkt zum richtigen Zeitpunkt dem interessierten Kunden anzubieten, ist ein solches Problem.

Daten aus unterschiedlichen Quellen müssen in einem analytischen Datenbestand zusammengeführt und in Echtzeit ausgewertet werden.

SAS Big Data Technologie

Um Daten schnell und kostengünstig für Analysen bereitzustellen, bietet sich Hadoop als Basistechnologie an. Für den unternehmensweiten Einsatz dieser Open-Source Lösungen sind häufig keine Mitarbeiter mit den notwendigen Kompetenzen an Bord. Deshalb wird auch von SAS Institute eine Reihe von Techniken angeboten, die diese Lücke schließen sollen.

Wir installieren die SAS Big Data Umgebung in Ihrem Haus

Wir beraten Sie bei der Auswahl der richtigen Strategie, Hardware und Software. Damit Sie loslegen können, sorgen wir für die notwendigen Schnittstellen, Berechtigungskonzept und alles Weitere. Lassen Sie uns über ein Startpaket reden! In Abhängigkeit von Ihrem Bedarf definieren wir den Umfang eines Gesamtpakets inklusive eines Initialpakets für die Datenintegration.

Wir installieren die SAS Big Data Umgebung in der Cloud

Wie bei der Inhouse-Strategie schnüren wir ein Startpaket, allerdings suchen wir mit Ihnen einen vertrauenswürdigen Cloud-Anbieter und installieren dort. Wenn Ihre Bedürfnisse wachsen, wächst die Cloud-Lösung mit. Ihre Wachstumsstrategie wird nicht durch die Technik limitiert.

SAS Big Data Lab

SAS hat die notwendige Infrastruktur für das Speichern, Managen und schnelle Analysieren von Daten für Sie zusammengestellt – in einem Komplettpaket aus Software, Consulting und Training für die selbständige Entwicklung von Big Data Use Cases zum Fixpreis.

Wir unterstützen bei der Einführung indem wir unsere Fachexpertise im Umfeld Marketing & Vertrieb einbringen und entwickeln, sowie Ihre analytischen Use Cases mit den Fachanwendern überprüfen.

Mehr Informationen zur SAS Lösung:

⇒ SAS® Big Data Lab

Event Stream Processing

Viele Prozesse verursachen einen umfangreichen und fortwährenden Datenstrom, der durch den laufenden Betrieb erzeugt wird (beispielsweise einer Online-Präsenz oder durch Maschinen- und Log-Daten). Das Ziel ist es, sinnvolle Zusammenhänge direkt aus dem Datenstrom in Echtzeit abzuleiten. Damit wird das Speichern von großen Datenmengen überflüssig und eine direkte Reaktion auf definierte Ereignisse in Echtzeit möglich.

Kunden, die sich über mehrere Online-Medien informieren oder Produkte ordern, können mit dieser Technologie direkt über die nächste Handlungsalternative informiert werden. Dafür ist die bekannte Kundenhistorie aus Datenbanken mit den Informationen über die aktuelle Online-Aktivität mittels einer Echtzeit-Komponente zu vernetzen.

Das Produkt “SAS® Event Stream Processing” verbindet die Verarbeitung kontinuierlicher Ereignisse mit der Erkennung von Mustern in den Daten. Event Stream Processing von SAS verbindet Datenqualität während des Streamings mit dem Abgleich von vorab konfigurierten analytischen Ausdrücken mit den Daten. Das macht Entscheidungen schneller und intelligenter.

Mehr Informationen zur SAS Lösung:

⇒ SAS® Event Stream Processing

Unsere Leistungen:

- Installation und Inbetriebnahme der Lösung

- Integration in Ihre Systemlandschaft

- Evaluation und Exploration für die Mustererkennung

- Implementierung von Modellen

Data Quality Management

Laut einer Studie des TDWI Forschungsinstituts entstehen amerikanischen Unternehmen pro Jahr Kosten in Höhe von 600 Mrd. USD durch ‚schlechte‘ Daten.

Im Zuge der digitalen Transformation und der noch stärkeren Verschmelzung der Geschäftsprozesse mit der IT ist ein zeitnaher Wechsel zu einem prozessorientierten Datenqualitätsmanagement einer der kritischen Erfolgsfaktoren zur nachhaltigen Sicherung und dem Ausbau der Wettbewerbsfähigkeit im digitalen Zeitalter.

Ob zur Findung von Geschäftsentscheidungen, Ergreifung datenbezogener Initiativen wie CRM oder ERP, die genaue Kenntnis von Kundendaten oder im Rahmen einer ganzheitlichen Data Governance – in jedem Geschäftsbereich ist die Qualität der heranzuziehenden Daten von großer Bedeutung.

Mit der DataFlux-DataQualityManagement-Umgebung bietet das SAS-Institute ein umfassendes Werkzeug für Datenqualität und Data Governance. Die integrierten Verfahren für die Planung, Durchführung und das Monitoring von Prozessen zur Steigerung der Datenqualität bilden einen bewährten Ansatz um ihre Daten zu analysieren, zu verbessern und zu kontrollieren.

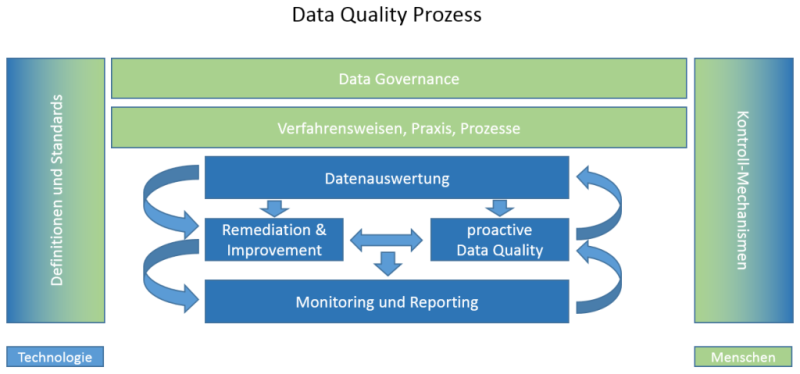

Um die Datenqualität eines Unternehmens dauerhaft zu verbessern bedarf es eines stetigen Prozesses unter der Beteiligung der hierfür verantwortlichen Personen und der notwendigen Technologien und Ressourcen:

Mit unserem ganzheitlichen Beratungsansatz helfen wir Ihnen einen auf Ihre Anforderungen abgestimmten Datenqualitätsprozess zu etablieren und die Potentiale Ihrer Daten mit Hilfe der DataFlux- SAS- Umgebung zu realisieren.

PLANEN - AGIEREN - KONTROLLIEREN

Eine konsequente Anwendung dieser Systematik mündet in einer einheitlichen Sicht auf Ihre Daten.

anaxima hilft Ihnen bei der Umsetzung der Prozesse und unser DQ-Team berät Sie gerne von der Installationsplanung bis zur Auswertung der Dashboards.

✗ Use Cases:

Risk-Management / BCBS 239

Das Enterprise Risk Management (ERM) gewinnt mit dem Aufkommen von Regulierungsinitiativen wie Basel III und BCBS 239 immer mehr an Bedeutung. ERM erfordert qualitativ hochwertige, integrierte Daten für risikoorientierte Entscheidungen. Ein Datenmanagementsystem ist die Grundlage für die Bereitstellung solcher Daten. Die Datenqualität ist ein wichtiger Bestandteil des Datenmanagements und stellt sicher, dass Entscheidungen auf Passdaten basieren. Durch die Entwicklung eines Datenqualitätsprogramms können qualitativ hochwertige Daten für Initiativen wie ERM sichergestellt werden. Dies sorgt für die Einhaltung von Regularien und treibt das Unternehmen zur Erreichung der Wettbewerbsdifferenzierung an.

Hohe Datenqualität ist ein zentraler Aspekt von BCBS 239. Unternehmensdaten, wie etwa Stammdaten von natürlichen Personen, juristischen Personen oder öffentlichen Haushalten, müssen daher hohe Ansprüchen an Beschaffenheit, Aktualität und Qualität erfüllen. Durch Validierungen, Standardisierungen und Entity Resolution können Datenqualitätsfaktoren bestimmt werden, die als Vergleichswerte für zukünftige Datenqualitätsprüfungen herangezogen werden können.

Marketing

Falsche Kundendaten führen zu falschen Ansprachen. Veraltetete oder nicht vollständige Daten führen zu einer erschwerten Kundenkommunikation und sind ein Grund für Irrläufer oder Mehrfachsendungen bei einem Mailing.

Ob durch Adressvalidierung, Dublettenfindung oder Anreicherung ihrer Daten durch Geocoding – es gibt viele Bereiche, in denen qualitätsverbesserte Informationen Ihnen helfen Geld zu sparen oder Ihren Kundenstamm zu erweitern.

Kreditwesen

Mangelnde Datenqualität kann erheblichen Einfluss auf die Höhe des zu hinterlegenden Eigenkapitals und somit auf die Liquidität haben – im Positiven wie im Negativen. Beispielsweise kann die Unternehmensform von Kreditnehmern noch auf dem Stand von vor 20 Jahren stehen, was die Ratingklasse dieser Kunden als zu niedrig einstuft. Oder die Kundenumsätze wurden in absoluten Zahlen und nicht in TSD-Einheiten erfasst, was zu falschen Ausgangswerten für Ausfallwahrscheinlichkeiten führt.

Eine detaillierte Analyse der risikorelevanten Daten und die Einführung und Überwachung von Business Rules (für das Beispiel p.e. eine ¼-jährliche Überprüfung der Unternehmensform) führt zu signifikant verbesserten Kennzahlen.

⇒ Zur Mitarbeitervorstellung

<

<